LLM(大規模言語モデル)とは何か?

初心者でもわかる仕組みとビジネス活用術

「LLMって最近よく聞くけど、いったい何なのだろう?」そう感じている方は少なくありません。ChatGPTをはじめとする対話型AIの登場により、LLM(大規模言語モデル)という言葉を耳にする機会が急増しました。しかし、その仕組みやビジネスでの活用方法については、まだ十分に理解されていないのが現状です。

本記事では、LLMの基本から実践的な活用法まで、初心者の方にもわかりやすく解説します。技術的な難しさを感じることなく、LLMの本質を理解し、自社のビジネスにどう取り入れるべきかが見えてくるはずです。

この記事でわかること

- LLM(大規模言語モデル)の定義と従来のAIとの違い

- LLMが文章を生成できる仕組みと学習プロセスの基本

- ビジネスで実際に活用できるLLMの具体的な機能

- カスタマーサポートやマーケティングなど業務への応用事例

- 導入時に注意すべきセキュリティやコストのポイント

この記事を読むことで、LLMを「難しい技術」ではなく「使える道具」として捉えられるようになります。専門用語は最小限にし、図解や具体例を交えながら説明していきますので、IT知識に自信がない方でも安心してお読みいただけます。ビジネスの現場で今日から使える知識が、ここにあります。

LLM(大規模言語モデル)とは

生成AIがビジネスシーンで注目を集める中、その中核技術として知られる「LLM(大規模言語モデル)」。一見難しく感じるかもしれませんが、実はシンプルな原理で動いています。では、LLMとは具体的にどのような技術なのでしょうか?

LLMの基本的な定義

LLM(Large Language Models、大規模言語モデル)とは、非常に巨大なデータセットとディープラーニング技術を用いて構築された言語モデルを指します。人間の言語を理解し、生成する能力を持つAIシステムであり、自然言語処理に特化したモデルとして幅広いタスクに対応できます。

「大規模言語モデル」は、言語モデルのうち「計算量」「データ量」「モデルパラメータ数」の3要素を大規模化したものを指します。この3つの要素を巨大化させることで、従来の言語モデルとは比較にならない高精度な処理を実現しました。

| 要素 | 説明 | 影響 |

|---|---|---|

| 計算量 | コンピュータが処理する仕事量 | 処理速度と学習精度の向上 |

| データ量 | 入力された文章データの情報量 | 言語パターンの理解精度向上 |

| パラメータ数 | ディープラーニング技術に特有の係数の集合体 | 複雑な文脈理解と生成能力 |

LLMは数十億ものパラメータによって言語の複雑なパターンを捉え、文脈から推測する能力、文脈に即したコヒーレント応答を生成する能力、英語以外の言語への翻訳能力、文章の要約能力などを備えています。例えば、野村総合研究所のデータによれば、2022年11月に発表されたChatGPTも「大規模言語モデル」の一種であり、格段に優れた受け答えにより、自然言語での応答の質を大幅に高めています。

従来のAIとの違い

従来のAIや言語モデルとLLMには、どのような違いがあるのでしょうか?実は、その違いは「規模」と「汎用性」にあります。

従来の自然言語処理モデルでは、特定のタスクごとに個別のモデルを構築し、人間がラベル付けを行う必要がありました。例えば、感情分析には感情分析用のモデル、翻訳には翻訳用のモデルを用意しなければならなかったのです。

しかし、LLMは異なります。LLMは特定のタスク(感情分析、固有表現抽出、数学的推論など)のために訓練されたものとは異なり、幅広いタスクに優れた汎用モデルです。つまり、一つのモデルで文章生成、翻訳、要約、質問応答など複数の処理を高精度で実行できるという特徴があります。

従来の言語モデルでは、テキストデータであれば単語に分割した後に人がラベル付けをする必要がありましたが、大規模言語モデルでは大量のテキストデータを与えることで、トークンから文脈や言葉の意味を学習できます。

| 比較項目 | 従来のAI/言語モデル | LLM(大規模言語モデル) |

|---|---|---|

| タスクの範囲 | 特定タスク専用 | 汎用的に多様なタスクに対応 |

| 学習方法 | 人間による手動ラベル付け | 大量データから自動学習 |

| パラメータ数 | 数百万~数千万程度 | 数十億~数千億以上 |

| 文脈理解 |

限定的 |

高度な文脈理解が可能 |

| アーキテクチャ | RNN、LSTMなど | Transformer基盤 |

LLMは深層学習技術と大量のテキスト・データを使用し、通常、生成型の事前トレーニング済みトランスフォーマーのようなトランスフォーマー・アーキテクチャーをベースとしています。この「Transformer」という技術が、LLMの飛躍的な性能向上の鍵となっています。

LLMが注目される背景

なぜ今、LLMがこれほど注目されているのでしょうか?その背景には、技術的なブレークスルーとビジネスニーズの両面があります。

技術的な側面では、2020年にOpenAIが発表した「Scaling Laws for Neural Language Models」という論文で、自然言語モデルの性能と「計算量」「データ量」「モデルパラメータ数」の3つの要素との間に「Scaling Law(べき乗則)」が成立すると提唱されました。この発見により、モデルを大規模化すればするほど性能が向上するという明確な指針が示されたのです。

ビジネス面では、チャットボットや検索エンジン、翻訳、顧客の声分析、議事録生成、文章要約など、自然言語を用いるさまざまなタスクに応用できるのではないかと期待されています。実際に、IBMによれば、LLMはますます多くのビジネス・プロセスを再定義しており、さまざまな業界における膨大なユースケースやタスクにおいて、その応用力の高さが証明されています。

市場への影響も見逃せません。ゴールドマン・サックスは2023年、言語生成AIは今後10年間で世界のGDPを7%増加させ、全世界で3億人の雇用を自動化にさらす可能性があると示唆しています。この予測からも、LLMが単なる技術トレンドではなく、社会全体を変革する可能性を秘めていることがわかります。

また、大手IT企業による開発競争も激化しています。Microsoftが提供するサーチエンジン「Bing」にChatGPTの改良版が搭載され、Microsoft以外にも、Googleが「Bard」、Metaが「LLaMA」を発表するなど、大手IT企業による開発競争が盛んになっています。

さらに、データの蓄積も進んでいます。言語データの蓄積は年率7%で増加しており、2022年10月現在、高品質な言語データは4兆6,000億語から17兆語の範囲内にあると推定されています。このように豊富なデータが利用可能になったことも、LLMの進化を後押ししています。

LLMの仕組みを初心者向けに解説

一見難しく感じるLLMの仕組みですが、実はシンプルな原理で動いています。では、どのようにして人間のような自然な文章を生み出しているのでしょうか?

この章では、LLMが膨大なデータから言語パターンを学び、次に続く最適な言葉を予測することで、まるで人間のような文章を生成する仕組みを、初心者でも理解できるように4つの観点から解説します。

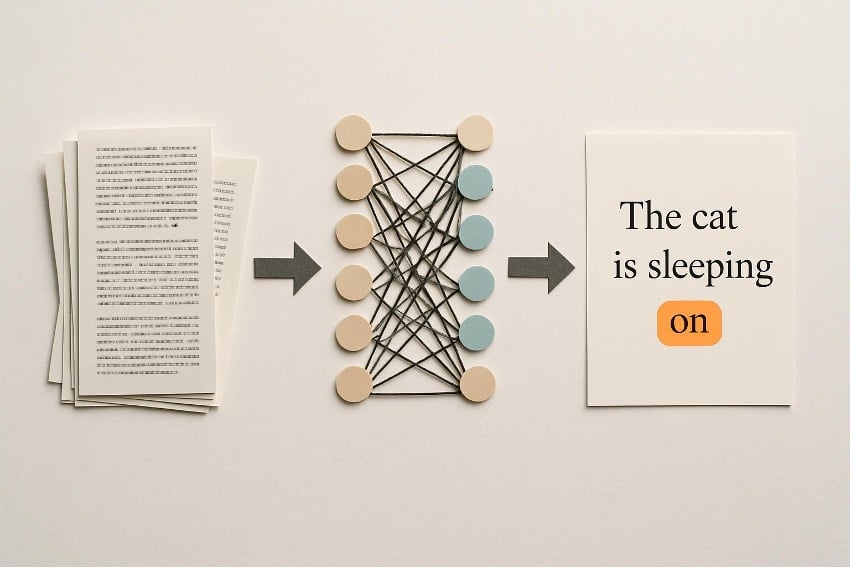

大規模言語モデルの学習プロセス

LLMは、事前学習(Pre-Training)と微調整(Fine-Tuning)の2段階のプロセスを経て、その能力を獲得します。これは、人間が基礎教育を受けた後に専門分野を学ぶプロセスに似ています。

まず、インターネット上のウェブページ、書籍、論文、ニュース記事などから大量のテキストデータを収集します。Common Crawl、The Pile、Wikipedia、GitHubなどが著名な事前訓練データとして知られています。この段階で、LLMは人間の言語の基本的なパターンや文法、文脈を広範囲に学習します。

次に、収集したデータを前処理します。前処理には、不要な情報の削除、テキストの正規化、トークン化(単語やフレーズを識別可能な単位に分割)などが含まれます。

| 学習ステージ | 目的 | データの種類 |

|---|---|---|

| 事前学習 (Pre-Training) |

言語の基本的なパターン、文法、文脈の習得 | ウェブページ、書籍、論文、ニュース記事など膨大な汎用データ |

| 微調整 (Fine-Tuning) |

特定タスク(文章要約、質問応答など)への最適化 | 特定分野の専門データ、人間のフィードバック |

ファインチューニングと呼ばれる手法を用いて、テキスト分類・生成や感情分析、文章要約、質問応答といったさまざまな自然言語処理(NLP)タスクに適応させます。この2段階のプロセスにより、LLMは幅広い言語タスクに対応できる汎用性と、特定分野での高い精度を両立しています。

整形されたデータが、モデルが言語パターンを学習するための基礎となるので、どのようなデータセットを収集するのかで完成するAIの性能も変わってきます。そのため、学習データの質と量は、LLMの性能を左右する最も重要な要素と言えるでしょう。

トークンとパラメータの役割

LLMの性能を理解する上で欠かせない2つの概念が「トークン」と「パラメータ」です。この2つは、LLMが言語を理解し生成する際の基盤となる要素です。

トークンとは何か

トークンとは、入力文を最小単位に分別したもので、通常、LLMを訓練する前にトークナイザを訓練データセットの全体に適用し、その後は凍結します。単語、部分単語、文字、記号などがトークンとして扱われます。

例えば、「人工知能は便利です」という文章は、「人工」「知能」「は」「便利」「です」のように分割されます。一般に、LLMはこれを行うために固有のトークナイザを使用し、テキストと整数のリストを対応させています。LLMは文字ではなく、このトークンの連なりとして言語を理解しているのです。

パラメータの重要性

パラメータは、モデルが訓練により、学習するにつれて収集する記憶のようなもので、モデルの知識バンクだと考えてください。大規模コーパスで事前訓練された、数百万から数十億以上のパラメータを持つディープラーニングモデルがLLMと呼ばれています。

従来の言語モデルと比較して、「計算量(コンピューターが処理する仕事量)」「データ量(入力された情報量)」「パラメータ数(ディープラーニング技術に特有の係数の集合体)」という3つの要素を大幅に強化することで、より高度な言語理解を実現しています。

| 要素 | 役割 | 例 |

|---|---|---|

| トークン | 文章を機械が理解できる最小単位に分割 | 「こんにちは」→「こんにち」「は」 |

| パラメータ | 学習によって獲得した知識を保存する変数 | GPT-3は1,750億、GPT-4はさらに大規模 |

パラメータ数が多いほど、LLMはより複雑な言語パターンを学習でき、精度の高い応答が可能になります。ただし、パラメータ数の増加は、必要な計算資源やコストの増大も意味します。

ニューラルネットワークの基本構造

LLMの核となる技術が「ニューラルネットワーク」です。これは、処理ユニットの層で構成されており、しばしば脳内のニューロンに例えられます。では、どのような構造で言語を処理しているのでしょうか?

3層構造のアーキテクチャ

LLMのニューラルネットワークは、一般的に入力層、中間層(隠れ層)、出力層の3層構造で構成されています。

| 層 | 役割 | 処理内容 |

|---|---|---|

| 入力層 | データの受け入れ | トークン化されたテキストデータを数値ベクトルに変換 |

| 中間層(隠れ層) | 特徴抽出と分析 | データの特徴や変数を複雑に計算し、言語パターンを抽出 |

| 出力層 | 結果の生成 | 人間が理解できる自然な文章として出力 |

具体的な処理の流れは次の通りです。ユーザーが「明日の天気は?」と質問すると、入力層でトークン化され数値データに変換されます。中間層では、文脈や意図を分析し、「天気予報を求めている」と理解します。最後に出力層で「明日は晴れで気温は25度の予想です」といった自然な応答を生成します。

Transformerアーキテクチャ

LLMはニューラルネットワーク(NN)の一種で、トランスフォーマーアーキテクチャを使用しています。大規模言語モデルでは、2018年以降、逐次データに対する標準的なディープラーニング手法となったTransformer(トランスフォーマー)アーキテクチャが最もよく使用されています。

このアーキテクチャは、データシーケンスの異なる部分間の依存関係を、距離に関係なく検出するように設計されているモデルです。例えば、長い文章の中で、離れた位置にある単語同士の関係性も正確に把握できます。

Transformerはエンコーダ型、デコーダ型、エンコーダ・デコーダ型の3つに分類され、それぞれ得意とするタスクが異なります。エンコーダ型は文章分類や感情分析に、デコーダ型は文章生成に、エンコーダ・デコーダ型は翻訳や要約に適しています。

自然言語処理技術との関係

LLMは、自然言語処理(NLP:Natural Language Processing)と呼ばれる分野における革新的な技術です。では、従来の自然言語処理とLLMはどのような関係にあるのでしょうか?

自然言語処理(NLP)の進化とLLM

LLMはディープラーニングアルゴリズムを使用してトレーニングされたモデルであり、感情分析、会話型質問応答、テキスト翻訳、分類、生成などの幅広い自然言語処理(NLP)タスクが可能です。

従来の言語モデルでは、テキストデータであれば単語に分割した後に人がラベル付けをする必要がありました。しかし、大規模言語モデルでは大量のテキストデータを与えることで、トークンから文脈や言葉の意味を学習できます。

| 比較項目 | 従来のNLP | LLMベースのNLP |

|---|---|---|

| 学習方法 | 人手によるルール設定とラベル付け | 大量データから自動的にパターン学習 |

| 対応タスク | 特定タスクに特化 | 複数タスクに汎用的に対応 |

| 精度 | 限定的な文脈理解 | 高度な文脈理解と自然な生成 |

| 開発コスト | 専門知識と手作業が必須 | データと計算資源が必要 |

LLMが実現する高度なNLPタスク

LLMは、大量のデータセットとディープラーニング技術を用いて構築された、機械学習の自然言語処理モデルとして、従来のNLP技術では困難だった以下のようなタスクを高精度で実行できます。

- 文脈理解:長い文章の中で、言葉の意味を文脈から正確に判断

- 感情分析:レビューやSNS投稿から顧客の感情を自動的に分類

- 質問応答:複雑な質問に対して、文脈に即した適切な回答を生成

- 文章要約:長文を重要なポイントに絞って簡潔にまとめる

- 多言語翻訳:複数の言語間で自然な翻訳を実現

LLMがタスクを実行する能力や対応可能な範囲は、ある意味では設計における画期的な進歩には依存せず、LLMに費やされた資源(データ、パラメータサイズ、計算力)の量の関数であるように見えます。つまり、より多くのデータと計算資源を投入することで、LLMの性能は向上し続ける可能性があるのです。

多数のパラメータを持ったニューラル言語モデルは、文の次の単語を予測するという単純なタスクで十分に訓練することで、人間の言語の構文や意味の多くを捉えられることがわかりました。この発見が、現在のLLMブームの基盤となっています。

LLMでできること

LLMは単なる文章生成ツールではありません。実は、ビジネスから日常生活まで、幅広い領域で私たちの作業を支援する多機能なAIツールなのです。では、具体的にどのようなことが可能なのでしょうか?主要な4つの機能について、実例を交えながら詳しく見ていきましょう。

文章生成と要約

LLMの最も代表的な機能が、文章の自動生成と長文の要約です。ChatGPTやClaude、Geminiなどのサービスを使えば、わずか数秒で高品質な文章を作成できます。

文章生成では、ブログ記事、メール文面、企画書、プレスリリースなど、あらゆる種類の文書を作成可能です。例えば「新製品発表のプレスリリースを300文字で」と指示すれば、適切な形式と文体で文章を生成してくれます。一から書く場合と比べて、作成時間を約70%削減できるという調査結果もあります。

要約機能も非常に強力です。数万文字の報告書や論文を数百文字に圧縮し、重要なポイントだけを抽出できます。忙しいビジネスパーソンにとって、情報収集の時間を大幅に短縮できる機能といえるでしょう。

| 機能 | 具体例 | 活用シーン |

|---|---|---|

| 文章生成 | ブログ記事、メール、企画書、広告コピー | コンテンツマーケティング、営業活動 |

| 要約 | 議事録の要点抽出、論文のサマリー作成 | 情報収集、会議の効率化 |

| リライト | 文章のトーン変更、別表現への言い換え | 読者層に合わせた文章調整 |

| 校正 | 誤字脱字チェック、文法修正 | 文書の品質向上 |

さらに、既存の文章を別の表現に書き換える「リライト機能」も備えています。専門的な文章を一般読者向けにやさしく書き直したり、逆にカジュアルな文章をビジネス文書調に変換したりすることが可能です。

質問応答と対話

LLMは、人間との自然な対話を通じて質問に答える能力を持っています。これは従来の検索エンジンとは大きく異なる点です。検索エンジンがキーワードに基づいてリンクを表示するのに対し、LLMは質問の意図を理解し、直接的な回答を生成します。

では、どのような質問に対応できるのでしょうか?実は、知識に関する質問から、複雑な問題解決のアドバイスまで、極めて広範囲にわたります。

「Python言語とは何ですか?」という基本的な質問から、「顧客満足度を向上させるための具体的な施策を5つ教えてください」といった実践的な相談まで、文脈を理解した上で適切な回答を返してくれます。さらに、一度の質問で終わらず、継続的な対話を通じて回答を深掘りできるのも特徴です。

例えば、最初に「在庫管理システムの選び方を教えてください」と質問し、その回答を受けて「中小企業向けでコストを抑えられるものは?」「クラウド型とオンプレミス型の違いは?」と追加の質問を重ねることで、より具体的で自社に適した情報を引き出せます。

| 対話の種類 | 活用例 | メリット |

|---|---|---|

| 情報検索型 | 「〇〇の定義は?」「〇〇の歴史について教えて」 | 複数のソースから統合された回答を即座に取得 |

| 問題解決型 | 「〇〇を改善するには?」「〇〇のトラブル対処法は?」 | 具体的な手順やアドバイスを段階的に取得 |

| ブレインストーミング型 | 「新商品のアイデアを10個出して」「キャッチコピー案を考えて」 |

短時間で多様な視点からのアイデアを獲得 |

| 学習支援型 | 「〇〇をわかりやすく説明して」「例を挙げて教えて」 | 理解度に応じた説明を何度でも受けられる |

ビジネスシーンでは、社内のナレッジベースとLLMを組み合わせた「社内用AIアシスタント」の導入が進んでいます。社員が業務上の疑問をチャット形式で質問すると、社内規定や過去の事例を参照しながら回答を生成するシステムです。これにより、ベテラン社員への問い合わせが減少し、業務効率が向上したという企業も増えています。

翻訳と多言語対応

LLMは、100以上の言語に対応した高精度な翻訳機能を提供します。従来の翻訳ツールと何が違うのでしょうか?最大の違いは、文脈を理解した上で自然な訳文を生成できる点です。

単語を機械的に置き換えるのではなく、文章全体の意味や文化的背景を踏まえた翻訳が可能です。例えば、日本語の「よろしくお願いします」という表現は、状況によって英語では"Thank you in advance"や"I look forward to working with you"など、異なる訳し方が適切ですが、LLMは文脈から適切な表現を選択します。

ビジネス文書の翻訳では、専門用語や業界特有の表現も正確に処理できます。「貸借対照表」「損益計算書」といった会計用語や、「コンバージョン率」「セッション数」といったマーケティング用語も、適切な訳語で翻訳されます。

| 翻訳の種類 | 活用場面 | LLMの強み |

|---|---|---|

| ビジネス文書 | 契約書、提案書、メール | フォーマルな文体の維持、専門用語の正確な翻訳 |

| 技術文書 | マニュアル、仕様書、論文 | 技術用語の一貫性、図表との連動 |

| マーケティング資料 | 広告コピー、Webサイト、SNS投稿 | 現地の文化に合わせた表現、キャッチーな言い回し |

| カスタマーサポート | 問い合わせ対応、FAQ | 丁寧な表現、顧客の意図の正確な理解 |

多言語対応の面では、複数言語を同時に扱う作業も効率化できます。例えば、日本語で作成したマーケティング資料を、英語、中国語、韓国語に一度に翻訳し、各言語版を数分で準備することが可能です。従来は翻訳会社に依頼すると数日から数週間かかっていた作業が、大幅に短縮されます。

さらに、翻訳の品質を自分で調整できるのも利点です。「もっとカジュアルな表現で」「専門家向けに技術的な用語を使って」といった指示を追加することで、目的や読者に合わせた翻訳結果を得られます。

グローバル展開を進める企業では、多言語対応のカスタマーサポートにLLMを活用しています。顧客からの問い合わせを自動で翻訳し、母国語で回答を生成することで、24時間365日、世界中の顧客に対応できる体制を構築できるのです。

コード生成とプログラミング支援

LLMは、プログラミングコードの自動生成とデバッグ支援において、開発者の強力なパートナーとなっています。プログラミング経験が少ない方でも、自然言語で指示を出すだけでコードを生成できる時代になりました。

では、具体的にどのようなプログラミング支援が可能なのでしょうか?主に以下の4つの領域で活用されています。

第一に、コードの自動生成です。「Pythonで顧客データをCSVファイルから読み込んで、年齢の平均値を計算するコードを書いて」と指示すれば、実行可能なコードが数秒で生成されます。Python、JavaScript、Java、C++など、主要なプログラミング言語のほぼすべてに対応しています。

第二に、既存コードの説明と理解支援です。他の開発者が書いた複雑なコードをLLMに読み込ませると、「このコードは何をしているのか」を日本語でわかりやすく説明してくれます。新しいプロジェクトに参加した際の学習時間を大幅に短縮できます。

| 機能 | 具体例 | 効果 |

|---|---|---|

| コード生成 | 関数作成、API連携、データ処理 | 開発時間の短縮(約30〜50%削減) |

| デバッグ支援 | エラー原因の特定、修正案の提示 |

バグ修正時間の短縮 |

| コードレビュー | コード品質のチェック、改善提案 | 保守性・可読性の向上 |

| テストコード作成 | ユニットテスト、統合テストの自動生成 | テストカバレッジの向上 |

| ドキュメント生成 | コメント追加、API仕様書作成 | チーム内の情報共有の効率化 |

第三に、バグの発見と修正です。エラーメッセージをLLMに入力すると、エラーの原因を特定し、修正方法を具体的に提案してくれます。「なぜこのエラーが起きているのか」の説明と共に、修正後のコードも提示されるため、初心者でもスムーズに問題を解決できます。

第四に、コードの最適化とリファクタリングです。動作はするものの効率が悪いコードを改善したり、可読性を高めるために書き直したりする際に活用できます。「このコードをより効率的に書き直して」と依頼するだけで、パフォーマンスが向上した代替コードを提案してくれます。

実際の開発現場では、GitHub Copilotなどのコーディング支援ツールが広く使われています。これらのツールはLLMを基盤としており、開発者がコードを書いている最中に次の行を予測して提案したり、コメントから実装を自動生成したりします。ある調査では、こうしたツールを使用することで開発速度が平均55%向上したという結果も報告されています。

プログラミング初心者にとっても、LLMは優れた学習ツールです。「このアルゴリズムを初心者向けに説明して」「具体例を使って教えて」といった質問を通じて、自分のペースで学習を進められます。また、「この課題を解くためのヒントをください」と尋ねれば、答えそのものではなく考え方を教えてくれるため、真の理解につながります。

ノーコード・ローコード開発の領域でも、LLMは大きな役割を果たしています。専門的なプログラミング知識がなくても、業務アプリケーションやWebサイトを構築できる環境が整いつつあります。これにより、IT部門に頼らず、各部署が自ら必要なツールを開発する「市民開発者」が増加しています。

ビジネスにおけるLLMの活用事例

では、LLMは実際のビジネスシーンでどのように活用されているのでしょうか?

人間の言葉を理解し、文脈に応じた柔軟な応答ができるため、問い合わせ対応や文書作成、ナレッジ検索など、さまざまな業務で活用が進んでいます。この章では、企業が実際にLLMを導入し成果を上げている具体的な活用事例を紹介します。

カスタマーサポートの自動化からマーケティング活動、業務効率化、そして教育分野まで、LLMの活用範囲は多岐にわたります。それぞれの分野で、どのような課題を解決し、どのような効果が得られているのかを見ていきましょう。

カスタマーサポートの自動化

カスタマーサポートの分野では、LLMを活用したチャットボットや自動応答システムが急速に普及しています。従来のチャットボットとは異なり、LLMは顧客の多様な問い合わせに対して柔軟に対応できる点が大きな特徴です。

LLMを活用することで24時間365日体制での顧客対応が可能になり、人的リソースの大幅な削減と顧客満足度の向上を同時に実現できます。

製品マニュアルとの連携で実現する高精度な回答

社内の製品マニュアルやよくある質問(FAQ)データなどをLLMに参照させることで、お客様からの問い合わせを極力自動化したい、というご相談をいただきました。このように、RAG(検索拡張生成)を用いることで、膨大な製品マニュアルの中から関連する情報を的確に提示できるようになります。

特に、話し言葉などのような自由記述の文章や、多少の誤字脱字などが含まれるテキストでも内容を理解することができます。これにより、顧客が正確な用語を使わなくても適切な回答を提供できるのです。

パーソナライズされた顧客対応の実現

顧客の過去のやり取りやプロファイルを分析することで、よりパーソナライズされたサービスを提供することができます。過去の問い合わせ履歴や購買履歴を参照しながら、一人ひとりの顧客に最適化された対応が可能になります。

例えば、小売業界の企業では、顧客一人ひとりのニーズに合わせたカスタマイズされた推薦を提供することで、顧客満足度を向上させることができました。このような個別対応により、顧客体験の質が飛躍的に向上しています。

| 従来のチャットボット | LLM活用チャットボット |

|---|---|

| 事前に用意されたシナリオに沿った対応のみ |

自由度の高い質問にも柔軟に対応 |

| 誤字脱字があると理解できない | 多少の誤字脱字でも内容を理解 |

| 一問一答形式の単純な対応 |

対話履歴を考慮した複雑な質問への回答 |

| 画一的な対応 | 顧客ごとにパーソナライズされた対応 |

応答時間の短縮と顧客満足度の向上

LLMを搭載したチャットボットを導入し、顧客からの問い合わせに対する応答時間を大幅に短縮しました。即座に回答が得られることで、顧客の待ち時間がなくなり、満足度が向上します。

また、複雑な問い合わせに対しても、ユーザーとの対話の中で追加情報を引き出しながら最適解に導く仕組みを実装することが可能です。これにより、一度の問い合わせで問題が解決する確率が高まっています。

マーケティングとコンテンツ制作

マーケティング分野では、LLMが広告テキストの生成からコンテンツ制作、市場分析まで幅広く活用されています。制作スピードと品質の両立が実現し、マーケティング担当者はより戦略的な業務に集中できるようになっています。

広告テキストの自動生成とPDCAサイクルの高速化

ChatGPT APIと同社独自の広告効果予測AIを連携させたシステムを構築。商品情報やターゲット層のデータを基に、効果が高いと予測される広告テキスト案をAIが自動で大量生成し、運用者が選択・微調整を行った実例があります。

この取り組みの結果、広告テキスト制作にかかる時間が大幅に短縮され、広告クリエイティブの制作・改善スピードが飛躍的に向上しました。従来は数日かかっていた広告文作成が、数時間で完了するようになったのです。

ターゲット市場の分析と戦略立案

LLMに「ターゲットとなる市場のデータ」をインプットし顧客のニーズや市場の変化、競合他社などを分析させることで効果的なマーケティング戦略を立案できます。膨大な市場データを短時間で分析し、インサイトを抽出できる能力は、マーケティング担当者にとって強力なツールです。

さらに、立案した戦略をベースに、アイデアの生成から広告文や商品名の生成、商品のイメージ案やブランドロゴの生成まで幅広い創造力を発揮してくれます。ただし、人間の最終的な判断とクリエイティブな視点は依然として不可欠です。

多様なコンテンツの迅速な制作

ブログ記事、SNS投稿、メールマーケティングの文面など、多様なコンテンツをLLMで効率的に制作できます。コンテンツのトーン&マナーやターゲット層に合わせた文章を瞬時に生成できるため、複数のチャネルで一貫性のあるメッセージを展開できます。

また、SEO対策を考慮したキーワードの最適配置や、読者の興味を引く見出しの提案なども可能です。マーケティング担当者は、AIが生成した初稿をベースに、ブランドの独自性を加えながら効率的にコンテンツを完成させています。

| 活用領域 | 具体的な用途 | 期待される効果 |

|---|---|---|

| 広告制作 | 広告テキスト、キャッチコピー、バナー文案の生成 | 制作時間の50〜70%削減、A/Bテストの高速化 |

| コンテンツ制作 | ブログ記事、SNS投稿、メールマガジンの執筆支援 | コンテンツ制作量の2〜3倍増加、品質の均一化 |

| 市場分析 | 顧客ニーズの抽出、競合分析、トレンド予測 | 分析時間の大幅短縮、データドリブンな意思決定 |

| 商品企画 | ネーミング案、商品説明文、ブランドストーリーの作成 | アイデア出しの効率化、多角的な視点の獲得 |

業務効率化とデータ分析

LLMは定型業務の自動化やデータ分析の効率化において、企業に大きなインパクトを与えています。社内に蓄積された膨大なテキストデータを活用し、業務プロセスを大幅に改善する事例が増えています。

社内データ活用による情報検索の効率化

社内データと連携可能でセキュリティが確保された生成AI活用基盤を導入。従業員はチャットでの情報検索・議事録要約・文書作成補助・翻訳・コード生成など、各自の業務に応じたAIアプリの利用を開始したという事例があります。

この結果、情報収集や資料作成にかかる時間が短縮され、従業員の作業効率が向上。また、定型的な業務が効率化されたことで、企画や改善提案など、よりクリエイティブな仕事に時間を割けるようになったのです。

商品分類や業務プロセスの自動化

メルカリの事例では、GPT-4などのLLMを活用し、商品タイトルや説明文から特徴を抽出・理解させ、最適なカテゴリ候補を生成するシステムを開発しました。

その効果として、従来の手法では難しかった、複雑な商品やニッチなカテゴリへの分類精度が向上。分類作業の自動化が進み、運用コストが削減されたことが報告されています。さらに、ユーザーが目的の商品を探しやすくなり、出品者・購入者双方の利便性が向上し、プラットフォーム全体の価値向上につながりました。

大量のテキストデータの要約と分析

LLMを用いて、アンケート結果を自動で要約・分類・可視化し、社員のモチベーションや不満点、改善要望などを高速に抽出したいというニーズが増えています。従業員アンケートや顧客フィードバックなど、大量の自由記述データから有意義なインサイトを抽出できます。

また、データ分析AIと組み合わせることで、どのような社員をどの組織に配属するのが適切か、といったことも合わせて分析して、組織戦略を最適化していくという取り組みも可能です。人事戦略の高度化にもLLMが貢献しています。

議事録作成やレポート作成の効率化

会議の音声をテキスト化し、LLMで要約・整理することで、議事録作成にかかる時間を大幅に削減できます。重要なポイントを自動抽出し、アクションアイテムを明確にすることで、会議の生産性も向上します。

社内に分散して大量に蓄積されている様々なドキュメントをナレッジとして活用することが可能となるため、過去の会議録や報告書から必要な情報を瞬時に検索できるようになります。情報の属人化を防ぎ、組織全体の知識共有が促進されます。

| 業務カテゴリ | LLM活用の具体例 |

|---|---|

| 情報検索 | 社内文書、マニュアル、過去資料からの情報抽出 |

| 文書作成 | 報告書、提案書、メール文面の下書き生成 |

| データ分析 | アンケート結果、顧客フィードバックの要約・分類 |

| 会議関連 | 議事録作成、アクションアイテムの抽出 |

教育と人材育成への応用

教育分野においても、LLMは学習体験の個別最適化と教育者の業務効率化の両面で大きな可能性を秘めています。一人ひとりの学習者に合わせたサポートが実現し、教育の質が向上しています。

個別最適化された学習支援の実現

LLMに各生徒の「学習状況」や「理解度・興味度」をインプットすることでその人に合う学習テキストやコンテンツ、指導方法を提供したり、必要に応じて補足説明や演習問題を提供することができます。これにより、従来の一斉授業では難しかった個別対応が可能になります。

実際に、学習の個別最適化や知識獲得のサポートが実現することで、生徒の成績を向上させる効果があることも示されています。それぞれの学習者のペースや理解度に合わせた学習環境を提供できることが、大きなメリットです。

営業人材育成でのロールプレイング活用

AIアバターを使った営業ロールプレイングや営業スキルに依存しない最適な提案などのLLM活用の相談が増えています。業界知識を学習させた仮想顧客として動くAIアバターとロールプレイングを行うことで、実際の商談に近いシミュレーションが可能になります。

AIアバターは、ロールプレイング中に発せられたキーワードや営業トークを評価し、改善点をフィードバックします。新人教育をより効率的かつ高品質で行うことができ、営業スキルの標準化と底上げが実現します。

教育者の業務負担軽減

試験の採点や添削、成績管理など手作業で行っている業務をLLMに任せることで教師の業務が効率化され、より生徒と向き合える時間が増えることが期待されています。定型的な業務から解放されることで、教育者は本来注力すべき指導や相談対応に時間を使えるようになります。

小論文やレポートの添削では、文法チェックだけでなく、論理構成や内容の深さについてもフィードバックを提供できます。教育者は最終的な評価と個別指導に集中でき、教育の質が向上します。

多様な学習コンテンツの生成

学習者のレベルや興味に合わせた演習問題、解説資料、学習ガイドをLLMで自動生成できます。多様な学習スタイルに対応したコンテンツを用意することで、学習者のモチベーション維持と理解度向上につながります。

また、多言語対応も容易なため、外国語学習や留学生向けの教材作成にも活用されています。教材の翻訳だけでなく、文化的背景を考慮した説明の追加など、きめ細かな対応が可能です。

| 教育分野での活用 | 提供される機能 | 期待される効果 |

|---|---|---|

| 個別学習支援 | 理解度に応じた説明、演習問題の提供、疑問への即答 | 学習効率の向上、苦手分野の克服 |

| 営業研修 | AIとのロールプレイング、トークスキルの評価とフィードバック | 研修時間の短縮、スキルの標準化 |

| 教材作成 | レベル別演習問題、解説資料、学習ガイドの自動生成 | 教材準備時間の削減、多様性の確保 |

| 評価業務 | 小論文添削、レポート評価、フィードバック作成 | 採点時間の短縮、指導の質の向上 |

このように、LLMはビジネスのあらゆる場面で活用が進んでおり、企業の競争力強化に貢献しています。ただし、導入にあたっては次章で述べる注意点やリスクを十分に理解し、適切な運用体制を構築することが成功の鍵となります。

LLM導入時の注意点とリスク

LLMの導入は大きな効果をもたらしますが、同時にさまざまな課題にも直面します。では、どのような点に注意すべきなのでしょうか?ここでは、企業がLLMを安全かつ効果的に活用するための重要なポイントを、実際の導入事例やデータに基づいて詳しく解説していきます。

情報の正確性と幻覚問題

LLMが直面する最大の課題の一つが、「ハルシネーション(幻覚)」と呼ばれる、事実に基づかない情報をもっともらしく生成してしまう現象です。一見正しそうに見える回答でも、実際には存在しない統計データや架空の事例を含んでいることがあります。

ハルシネーションが発生する主な原因

ハルシネーションは、LLMが学習データのパターンから「それらしい」回答を確率的に生成する仕組みに起因します。具体的には以下のような状況で発生しやすくなります。

- 学習データに含まれていない専門的な質問への回答

- 最新情報や時事問題に関する問い合わせ

- 曖昧な質問や文脈が不明確な指示

- 複数の情報を組み合わせた複雑な回答を求められた場合

正確性を高めるための具体的対策

カナダのAI企業Cohereが開発する「Commandシリーズ」は、RAG(検索拡張生成)技術に優れ、ハルシネーションを抑制します。このように、技術的なアプローチでリスクを軽減することが可能です。

| 対策手法 | 具体的な実施内容 | 期待される効果 |

|---|---|---|

| RAG(検索拡張生成)の実装 | 企業内の信頼できるデータベースや公式文書から情報を検索し、それを基に回答を生成する | 事実に基づく正確な情報提供が可能になり、ハルシネーションを大幅に削減 |

| 回答の根拠となる情報源の明示 | 生成された回答とともに参照元の文書やURLを表示する機能を実装 | ユーザーが情報の信頼性を自ら確認でき、透明性が向上 |

| 人間によるレビュー体制の構築 | 重要な意思決定に関わる回答は必ず専門家が確認する運用ルールを設定 | 誤情報による業務リスクを最小化し、品質を担保 |

| 信頼スコアの設定 | LLMが生成する回答に確信度を表示し、低スコアの場合は警告を出す | 不確実な情報への依存を防ぎ、適切な判断を促進 |

業務での実践的な運用ルール

技術的対策に加えて、運用面でのルール設定も重要です。例えば、マクニカでは生成AIをチャットボットとして顧客サポートに活用しようとしましたが、実際の利用率が低く、その結果期待した効果を得られないという失敗がありました。こうした失敗を避けるため、以下のような運用ルールを設定しましょう。

- 法的判断や医療診断など、高度な専門性が求められる分野ではLLMの単独利用を禁止

- 顧客向けの回答には必ず人間による最終確認を実施

- 定期的にLLMの出力品質を監査し、問題があれば即座に改善

- ユーザーフィードバック機能を設け、誤情報を早期に発見できる仕組みを構築

セキュリティとプライバシー保護

クラウド型はスケーラビリティが高い反面、データのプライバシーやセキュリティに関する懸念が伴うことが多く、企業にとって深刻なリスクとなります。では、具体的にどのようなセキュリティリスクがあるのでしょうか?

LLM導入で生じる主なセキュリティリスク

LLMを業務で利用する際には、以下のような多層的なセキュリティリスクを理解しておく必要があります。

| リスクの種類 | 具体的な脅威 | 想定される被害 |

|---|---|---|

| 機密情報の漏洩 | 社員がクラウド型LLMに顧客情報や社内機密を入力してしまう | 個人情報保護法違反、企業秘密の流出、信頼失墜、訴訟リスク |

| プロンプトインジェクション攻撃 | 悪意のある指示を含む入力により、LLMが意図しない動作をする | 不適切な情報の出力、システムの誤作動、セキュリティ制御の回避 |

| モデルの盗用 | カスタマイズした独自のLLMモデルが外部に流出する | 競争優位性の喪失、開発コストの無駄、知的財産の侵害 |

| 学習データへの汚染攻撃 | 悪意のあるデータを学習させることでモデルの動作を改変 | 誤った判断の蓄積、バイアスの増幅、信頼性の低下 |

効果的なセキュリティ対策の実装方法

組織は、「トラフィック上の脅威の監視」、「データの可視性」、「データ損失防止(DLP)の適用」、「リスクのあるアクティビティのフィルタリングと隔離」などの多層的なセキュリティ対策を取ることが重要です。

特に効果的な対策として、ローカルLLMの導入が注目されています。ローカルLLMは、これらの懸念を大幅に軽減することができるため、特にセキュリティが重視される業界での採用が進んでいます。金融機関では、顧客情報や取引履歴などの機密情報を扱うため、セキュリティが非常に重要視されますが、ローカルLLMを活用することでこれらの課題を解決できます。

プライバシー保護のための運用体制

技術的な対策だけでなく、組織全体でのプライバシー保護の意識向上も不可欠です。以下のような運用体制を整備しましょう。

- LLM利用に関する社内ガイドラインの策定と全社員への教育実施

- 入力データの種類に応じたアクセス権限の設定と監視

- 個人情報や機密情報を自動検出してブロックするフィルタリング機能の導入

- 定期的なセキュリティ監査とリスク評価の実施

- インシデント発生時の対応フローと責任者の明確化

コンプライアンスへの対応

AIの倫理的な使用やコンプライアンスの確保、特に個人情報保護や著作権に関する法的要件への対応が必要です。業界や地域によって異なる規制に対応するため、法務部門と連携した体制を構築することが重要です。

コストと運用体制

LLMの導入には、一見見えにくいコストが多数存在します。初期投資だけでなく、継続的な運用コストも含めた総所有コスト(TCO)を正確に把握することが成功の鍵となります。

LLM導入にかかる具体的なコスト構造

| コスト項目 | 具体的な内容 | 目安金額・注意点 |

|---|---|---|

| 初期導入費用 | システム設計、カスタマイズ、インフラ構築、データ整備 | 数百万円〜数千万円。要件や規模により大きく変動 |

| APIアクセス料金(クラウド型) | トークン数に応じた従量課金、モデルのサイズにより単価が変動 | 月間数万円〜数百万円。利用量が予測しにくく予算超過リスクあり |

| ハードウェア費用(ローカル型) | 高性能GPU搭載サーバ、ストレージ、ネットワーク機器 | 数百万円〜数千万円。高性能なGPUや専用ハードウェアが必要で、初期投資として大きな費用がかかる |

| 人材育成・研修費用 | AI人材の採用・育成、全社員向けトレーニング、外部講師費用 | 年間数十万円〜数百万円。継続的な投資が必要 |

| 保守・運用費用 | システム監視、セキュリティ更新、トラブル対応、モデルの再学習 | 月間数十万円〜。専任担当者の人件費を含めると高額化 |

| ライセンス費用 | 商用LLMモデルの利用料、関連ツールのサブスクリプション | 年間数十万円〜数百万円。利用規模により変動 |

費用対効果を最大化するための戦略

LLMOpsの枠組みを活用することで、単なるコスト削減だけでなく、ビジネス価値の創出という観点からLLM導入の効果を最大化することが可能になります。効果的な導入のためには、以下のアプローチが有効です。

- スモールスタートで効果を検証してから段階的に拡大

- 効果測定が容易な業務領域から優先的に導入

- クラウド型とローカル型のハイブリッド運用でコスト最適化

- 既存のITインフラを活用した段階的な投資

運用体制の構築における重要ポイント

LLM導入の成功には、組織全体での理解と協力が不可欠です。特に、経営層の理解と支持は、LLM導入に欠かせません。以下のような体制を整備しましょう。

| 役割 | 主な責任 | 必要なスキル・知識 |

|---|---|---|

| プロジェクトオーナー(経営層) | 戦略的方向性の決定、予算承認、組織横断の調整 | ビジネス戦略理解、意思決定力、AI活用の基礎知識 |

| AIプロジェクトマネージャー | 導入計画の立案、進捗管理、各部門との調整 | プロジェクト管理、技術と業務の橋渡し、リスク管理 |

| AIエンジニア・データサイエンティスト | モデル選定、カスタマイズ、性能評価、技術的問題解決 | 機械学習、自然言語処理、プログラミング、統計学 |

| インフラ担当者 | システム構築、セキュリティ対策、運用監視、障害対応 | クラウド・オンプレミス技術、ネットワーク、セキュリティ |

| 業務担当者(現場部門) | 要件定義、テスト、フィードバック、日常的な利用と改善提案 | 業務プロセス理解、LLM活用スキル、問題発見力 |

| 法務・コンプライアンス担当者 | 法規制対応、契約確認、リスク評価、ガイドライン策定 | 関連法規の知識、AI倫理、リスクマネジメント |

人材不足への対処法

AIやデータの知識を持つ専門人材が社内にいない、あるいは不足しているという課題は多くの企業が抱えています。この課題に対しては、以下のような多角的なアプローチが効果的です。

- 外部の専門企業やコンサルタントとの協業体制の構築

- 存社員へのAI教育プログラムの実施と社内AI人材の育成

- 導入初期は外部リソースに依存し、段階的に内製化を進める計画

- AIコミュニティへの参加や勉強会の開催による知識共有の促進

段階的な導入プロセスとKPI設定

具体的なKPIの設定と、パイロットプロジェクトによる効果実証が有効です。例えば、LLM導入によりカスタマーサポート業務での応答時間が50%短縮されたとか、文書作成業務の効率が30%向上したなど、数値で示せる成果を提示することが重要です。

効果的な導入のために、以下のような段階的なアプローチを推奨します。

- PoC(概念実証)フェーズ:小規模な実験で技術的実現可能性を検証(1〜3ヶ月)

- パイロット導入フェーズ:特定部門での限定的な本番運用と効果測定(3〜6ヶ月)

- 段階的拡大フェーズ:成功事例をもとに他部門へ展開(6〜12ヶ月)

- 全社展開・最適化フェーズ:組織全体での活用と継続的改善

特に、導入効果が測定しやすく、かつ効率化によるメリットが大きい業務から試すと、費用対効果が高くなりやすいです。各フェーズで明確な成功基準を設定し、定量的な評価を行うことで、投資判断の精度を高めることができます。

LLMの今後の展望

LLMはすでに私たちのビジネスや生活に深く浸透していますが、その進化はさらに加速しています。では、今後どのような方向に技術が進化し、ビジネス環境にどのような影響をもたらすのでしょうか?このセクションでは、技術の進化トレンドとビジネスへの影響という2つの視点から、LLMの未来像を具体的に解説します。

技術進化の方向性

LLMの技術革新は、複数の方向性で同時に進行しています。ここでは特に注目すべき3つのトレンドをご紹介します。

マルチモーダル統合の進展

今後のLLMは、単なるテキスト処理を超えた「複合知能」へと進化する見込みです。画像・音声・動画など複数の情報源を統合して理解・生成するマルチモーダル統合が注目されており、GPT-4oやGemini 1.5がその代表例となっています。

たとえば、製品マニュアルの画像を読み込ませて質問すると、その内容を解釈して音声で説明してくれるといった、複数の感覚を統合した対応が可能になります。これにより、従来は別々のツールで処理していた業務を一つのシステムで完結できるようになるでしょう。

長文・長期記憶対応の強化

数十万〜百万トークン単位の文脈処理に対応したモデルの登場により、膨大な資料を一度に読み込んで分析することが現実的になりました。Gemini 1.5やClaude 3 Opusがこの領域をリードしています。

具体的には、契約書数十ページ分を一度に読み込ませてリスク分析を依頼したり、過去1年分の会議録を参照しながら戦略提案を受けたりといった使い方が可能です。これまで人間が何時間もかけていた作業が、数分で完了する時代が到来しています。

エージェント型LLMの台頭

複数タスクを自律的に実行するエージェント型LLMの進展も見逃せません。Auto-GPTやChatDevといった事例では、目標を指示するだけで、必要な手順を自ら考えて実行する能力を備えています。

たとえば「来月の展示会の準備をして」と指示すると、会場予約、資料作成、参加者への連絡といった一連の業務を自動で進めるといった活用が期待されます。これは単なる「作業支援」を超えて、「業務の代行者」としての役割を果たすようになる可能性を示しています。

新興プレイヤーの台頭と技術の多様化

これまでの大手(OpenAI、Google、Anthropic)に加え、新興企業による革新的モデルの登場が相次いでいます。注目すべきプレイヤーを以下にまとめます。

| 企業・組織 | 主要モデル | 特徴 |

|---|---|---|

| Mistral(フランス) | Mixtral | 複数のモデルを組み合わせた構造(MoE:Mixture of Experts)で高精度かつ軽量を実現 |

| xAI | Grok | X(旧Twitter)に統合され、リアルタイム性や対話の鮮度を重視 |

| Cohere | Command Rシリーズ | 商用向けに開発され、文書検索や企業ナレッジ活用に強い |

| 国立情報学研究所 | LLM-jp | 日本語に最適化された学術研究用モデルを開発 |

これらのプレイヤーは、透明性・分散処理・低リソース対応といった観点で新たな方向性を打ち出しています。特に中小企業でも導入しやすい低コストモデルの登場により、LLM活用の裾野がさらに広がることが期待されます。

オンデバイス・プライバシー重視の方向性

「オンデバイスで動くLLM」や「自社専用に微調整されたLLM」のニーズも高まりつつあり、カスタマイズ性とプライバシー重視の方向性も強化されています。

これにより、機密情報を外部サーバーに送信せず、自社内のデバイスやサーバーだけでLLMを運用できるようになります。金融機関や医療機関など、情報管理が厳格な業界での活用が一層進むでしょう。

スケール則の限界と新たな学習手法

一方で、技術的な課題も浮上しています。GPT-5のリリースが2024年から2025年以降にずれこんだ理由として、大規模言語モデル(LLM)の開発を支配してきた「スケール則(Scaling law)」がそろそろ限界に近付いていることが指摘されています。

スケール則とは、「LLMはその規模(パラメーターの数)を大きくすればするほど、また機械学習するテキスト・データなどの量を増やせば増やすほど、その性能は指数関数的に上昇する」という経験則です。しかし学習用データの枯渇や計算コストの増大により、単純な規模拡大では性能向上が難しくなりつつあります。

そこで注目されているのが「推論能力の強化」です。OpenAIが2024年12月に発表した「o3」は、推論能力に優れ、ソフト開発やコンピュータ・プログラミングの性能評価試験で前モデルのo1よりも44~47パーセントも成績が向上しました。今後はデータ量よりも「思考の質」を高める方向にシフトしていくと考えられます。

価格競争の激化とAPI利用の民主化

DeepSeekの台頭は、中国におけるLLM API市場の価格競争を激化させており、複数の中国系ベンダーが推論コストを大幅に引き下げています。これにより、クラウドベースのAI推論ワークロードへ移行する動きが加速する可能性があります。

価格低下は中小企業やスタートアップにとって朗報です。従来は大企業しか導入できなかった高度なLLM機能が、月額数千円から利用できるようになる日も近いでしょう。これにより、あらゆる規模の企業がAIを活用した競争に参加できる環境が整います。

ビジネス環境への影響

技術進化がビジネスにどのような変化をもたらすのか、具体的な影響を見ていきましょう。

業務プロセスの根本的な再設計

LLMの高度化により、これまで「人間にしかできない」と考えられていた業務が自動化されます。ではどのような業務変化が起こるのでしょうか?

たとえば契約書レビュー業務では、従来は法務担当者が数時間かけて精読していたものが、LLMを活用すれば数分でリスク箇所を抽出できます。カスタマーサポートでは、複雑な問い合わせにも自動で対応できるようになり、人間のオペレーターは特に難しいケースだけを担当すればよくなります。

これは単なる「効率化」ではありません。人間はより創造的な業務や戦略的な判断に集中できるようになり、仕事の質そのものが変化するのです。

専門職の役割シフト

「AIの最重要課題とリスク」「コンピューティングのニュー・フロンティア」「人間とマシンの相乗効果」という3つの視点から、テクノロジの進化が企業活動や社会にもたらす変化を理解することが重要です。

専門職においても、LLMは単なる「ツール」から「協働するパートナー」へと進化します。たとえば医療現場では、医師が診断を下す際にLLMが最新の医学論文を参照して補助情報を提供したり、弁護士が訴訟戦略を立てる際に過去の判例を瞬時に分析したりといった使い方が広がるでしょう。

専門職の価値は「知識量」から「判断力」や「倫理的配慮」へとシフトしていきます。LLMが提供する情報を適切に評価し、最終判断を下す能力がこれまで以上に求められるようになります。

中小企業の競争力向上

価格低下と使いやすさの向上により、中小企業でもLLMを活用した業務改革が可能になります。これまで大企業にしかできなかった高度なデータ分析やマーケティング施策が、限られたリソースでも実現できるようになるのです。

たとえば顧客データを分析して購買傾向を予測したり、SNSの投稿を自動生成して継続的に情報発信したりといった施策が、専門人材を雇用しなくても実行できます。これにより、企業規模による情報格差が縮小し、アイデアと実行力がある企業が成長しやすい環境が整います。

新たな職種の誕生

LLMの普及に伴い、新しい職種も生まれています。「プロンプトエンジニア」はその代表例です。LLMから最適な回答を引き出すための指示文(プロンプト)を設計する専門家として、すでに多くの企業で需要が高まっています。

また「AIコンプライアンス担当者」や「AI倫理アドバイザー」といった、LLMの適切な運用を監督する役割も重要になるでしょう。技術の進化は雇用を奪うだけでなく、新たな働き方や職種を創出する側面も持っているのです。

グローバル競争の激化と日本の課題

ChatGPTの1週間のアクティブユーザー数は1億人を超え、開発元のOpenAIは1か月間で120億円を売り上げていると言われています。この数字は、LLM市場の巨大さを物語っています。

一方で日本は、英語圏に比べて日本語データの蓄積が少ないため、日本語特化型LLMの開発が課題となっています。国立情報学研究所の大規模言語モデル研究開発センターをはじめとする研究機関が、産学官連携で日本語LLMの開発を進めていますが、グローバル競争に遅れをとらないためには、さらなる投資と人材育成が必要です。

AI導入戦略の再評価の必要性

API料金が下がり続けることでAI導入戦略を再評価する必要性が高まっています。企業は今後、オンプレミス運用とクラウド運用のどちらが自社に適しているか、どのLLMプロバイダーを選択すべきかといった判断を定期的に見直す必要があるでしょう。

またLLMの基本原理や評価手法、導入に伴うさまざまな考慮事項を十分に理解し、適切かつ責任をもって活用することが、企業や組織にとって極めて重要です。単にツールを導入するだけでなく、その仕組みを理解し、リスクを管理しながら活用する体制を構築することが求められます。

社会インフラとしてのLLM

今後LLMは、電気やインターネットのように「あって当たり前」の社会インフラとして位置づけられる可能性があります。行政サービスの問い合わせ対応、教育現場での学習支援、医療における診断補助など、公共分野での活用も広がるでしょう。

このとき重要になるのが「公平性」と「透明性」です。特定の企業や個人だけが恩恵を受けるのではなく、すべての人がLLMの利点を享受できる仕組みづくりが求められます。また、AIがどのような判断基準で回答を生成しているのかを説明できる「説明可能AI」の技術開発も不可欠です。

LLMの今後は、技術的な進化だけでなく、それをどのように社会に実装し、誰もが安心して利用できる環境を整えるかという「社会的な課題」とセットで考える必要があります。技術とビジネス、そして社会全体のバランスを取りながら進化していくことが、LLMの真の可能性を引き出す鍵となるでしょう。

よくある質問(FAQ)

LLMとChatGPTは同じものですか?

ChatGPTはLLM(大規模言語モデル)を活用したサービスの一つです。LLMは技術の総称であり、ChatGPT以外にもClaude、Gemini、GPT-4など様々なLLMが存在します。ChatGPTはOpenAIが開発したGPTシリーズのLLMを基盤としています。

LLMを使うには専門知識が必要ですか?

基本的な利用であれば専門知識は不要です。ChatGPTやClaude、Geminiなどのサービスは、普段使う日本語で質問や指示を入力するだけで利用できます。ただし、ビジネスで本格的に活用する場合や、APIを使った独自システムの構築には一定の技術知識が求められます。

LLMは無料で使えますか?

多くのLLMサービスには無料プランがあります。ChatGPT、Claude、Geminiなどは基本機能を無料で利用可能です。ただし、無料版には利用回数の制限や機能制限があり、より高度な機能や大量の利用には有料プランへの加入が必要になります。

LLMが生成した情報はどこまで信頼できますか?

LLMは有用な情報を提供しますが、100%正確とは限りません。誤った情報や存在しない情報を自信を持って提示する「幻覚(ハルシネーション)」という現象が起こることがあります。そのため、重要な意思決定や公開情報には必ず人間による事実確認が必要です。特に数値データ、法律情報、医療情報などは専門家による検証が不可欠です。

社内の機密情報をLLMに入力しても大丈夫ですか?

無料版のLLMサービスでは、入力した情報がモデルの学習に使われる可能性があるため、機密情報の入力は避けるべきです。ビジネス利用では、データが学習に使われない有料プラン、またはMicrosoft Azure OpenAI ServiceやAmazon Bedrockなどの企業向けサービスの利用を検討しましょう。社内規定の整備も重要です。

LLMを導入するにはどのくらいの費用がかかりますか?

導入費用は利用方法によって大きく異なります。既存のサービスを利用する場合、個人向けは月額2,000円〜3,000円程度、企業向けは従業員数や利用量に応じて月額数万円から数十万円です。独自のLLMを構築・運用する場合は、数百万円から数千万円規模の初期投資と継続的な運用コストが必要になります。

LLMで業務効率化できる具体例を教えてください

代表的な活用例として、メール下書きやレポート作成などの文書作成業務で50%以上の時間削減、顧客からの問い合わせへの初期対応の自動化、会議議事録の要約作成、プログラミングのコード生成支援などがあります。多くの企業で、定型的な業務や情報整理作業にLLMを活用し、社員がより創造的な業務に集中できる環境を実現しています。

日本語と英語でLLMの性能に違いはありますか?

多くのLLMは英語データを中心に学習しているため、英語の方が高い精度を発揮する傾向があります。ただし、ChatGPT、Claude、Geminiなどの主要サービスは日本語にも十分対応しており、ビジネス利用において実用的なレベルに達しています。より高度な日本語処理が必要な場合は、日本語に特化したLLMの利用も検討できます。

まとめ

LLM(大規模言語モデル)は、膨大なテキストデータから学習し、人間のような自然な文章生成や対話を可能にするAI技術です。従来のAIと比較して汎用性が高く、特定タスクのための個別学習が不要という点で革新的といえます。

その仕組みは複雑に見えますが、本質的には「大量の文章を読み込み、単語の関係性やパターンを学習する」というシンプルな原理に基づいています。ニューラルネットワークと呼ばれる構造により、文脈を理解し適切な応答を生成できるのです。

ビジネスにおけるLLMの活用範囲は広く、カスタマーサポート、マーケティング、業務効率化、教育など多岐にわたります。実際に多くの企業が導入を進め、業務時間の削減やサービス品質の向上を実現しています。

一方で、情報の正確性に関する「幻覚」問題、セキュリティやプライバシーのリスク、導入・運用コストなど、注意すべき点も存在します。これらのリスクを理解し適切に対処することが、LLMを効果的に活用する鍵となります。

LLM技術は今後も急速に進化し、より高精度で多機能なモデルが登場するでしょう。ビジネス環境においても、LLMを前提とした新しい働き方やサービスが標準となっていくと予想されます。

重要なのは、LLMを単なるツールとして捉えるのではなく、ビジネス戦略の一部として位置づけることです。自社の課題や目標を明確にし、それに適したLLMの活用方法を検討することで、競争力の向上につなげることができます。

【個別相談】貴社の課題に合わせた生成AI活用を提案

無料相談フォームより、BtoB マーケティングにおける生成AI活用に関するご相談やお悩みをお聞かせください。お客様の業界・業種に応じた最適な活用方法をご提案いたします。

無料相談で得られること:

・貴社の課題に特化した BtoB マーケティングにおける生成 AI 活用方法の提案

・ROI 試算とコスト効果分析

・導入ロードマップの作成

・リスク対策とガバナンス設計のアドバイス

・成功事例に基づくベストプラクティスの共有

初回相談は無料です。ぜひお気軽にご連絡ください。